如果您的网站像房子一样,则进入该房子时应遵循Robots.txt文件。访客回家的第一件事就是阅读房屋规则,并知道房东是否允许其参观。

Robots.txt是网站管理员创建的文本文件,用于指导机器人(搜索引擎蜘蛛)如何在其网站上抓取页面并为其编制索引。因此,正确配置Robots.txt文件非常重要。如果您的网站包含敏感信息,不想向公众公开,请在此处进行设置。此外,合理的配置还可以帮助您很好地进行SEO。

SEO中Robots.txt的重要性

Robots.txt 在SEO中具有重要作用。它可以帮助搜索引擎自动到达您要搜索的页面并对该页面建立索引。但是,大多数网页的目录或文件不需要搜索引擎机器人即可访问。添加机器人文件将极大地帮助您进行SEO。

Robots.txt的配置

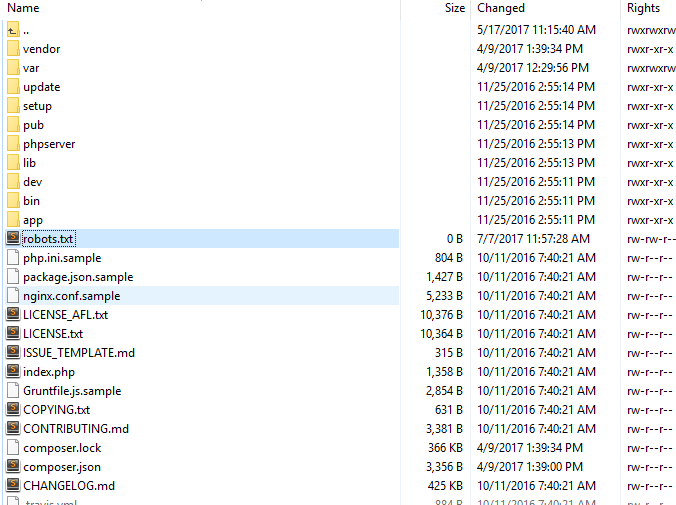

本质上,Robots.txt是放置在主机根目录中的非常简单的文本文件。您可以使用任何文本编辑器来创建。例如记事本。以下是WordPress的简单robots.txt结构:

- User-agent: * All bots are allowed to access.

- Allow: / Allows to detect and index entire pages and directories

- Disallow: /admin/ Block two wp-admin and wp-includes folders

- Sitemap: Diagram of the website

如何使用Robot.txt

- 不允许漫游器访问您不需要的任何目录

- 封锁一页

- 阻止某个机器人

- 从Google图片中删除一张图片

- 一起使用“允许”和“禁止”

- 锁定整个网站,而不是让机器人索引

使用时应避免的一些错误

当您重复使用某人的robots.txt或为您的网站创建自己的robots.txt时,不可避免会出现一些错误。

- 区分大小写字母。

- 每个语句应写在一行上。

- 不要写过多或缺少空白。

- 除命令语法外,请勿插入任何其他字符。

结论

如果没有Robots.txt,搜索引擎将可以自由运行以对它们在网站上找到的任何内容进行爬网和编制索引。但是,创建Robots.txt将有助于搜索引擎从您的网站抓取。因此,您的网站将受到更多的赞赏。